- Leistungen

Technologie-Lösungen

Technologie-Lösungen- Produktstrategie & Experience DesignDefinieren Sie softwaregetriebene Wertschöpfungsketten, schaffen Sie zielgerichtete Interaktionen und entwickeln Sie neue Segmente und Angebote.

- Digitale GeschäftstransformationPassen Sie sich an, entwickeln Sie sich weiter und gedeihen Sie in einer digitalen Welt.

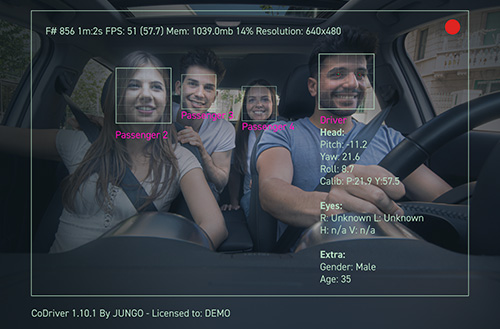

- GeheimdiensttechnikNutzen Sie Daten und KI, um Produkte, Prozesse und Ergebnisse zu transformieren.

- Software-ProduktentwicklungBeschleunigen Sie die Bereitstellung von Produkten, Plattformen und Services.

- Technologie-ModernisierungSteigern Sie Effizienz und Agilität durch modernisierte Systeme und Anwendungen.

- Eingebettete Technik + IT/OT-TransformationEntwickeln und betreiben Sie Chip-to-Cloud-Software für vernetzte Produkte.

- Branchen

- GlobalLogic VelocityAI

- Insights

BlogsDezember 20, 2024Axel SalmeronSieben Schlüssel, um Mitglied eines effektiven Teams zu sein

Ein großartiger Entwickler muss sowohl seine technischen Fähigkeiten als auch seine Sof...

BlogsDezember 13, 2024Manuel Asenzo

BlogsDezember 13, 2024Manuel Asenzo5 Gründe, warum Ihr Projekt einen Business Analyst braucht

Die Durchführung eines Projekts ist eine komplexe Herausforderung. Als Produktmanager s...

- Über

Press ReleaseGlobalLogicJanuar 14, 2025GlobalLogic gibt Führungswechsel bekannt: Srini Shankar zum ...

SANTA CLARA, Kalifornien–January 14, 2025–GlobalLogic Inc., ein Unternehmen...

Press ReleaseGlobalLogicJanuar 8, 2025

Press ReleaseGlobalLogicJanuar 8, 2025GlobalLogic und Hitachi Systems Trusted Cyber Management ...

GlobalLogic und Hitachi Systems Trusted Cyber Management, bekannt als die Cyber Securit...

- Karriere

BlogsBlogsBlogsBlogsBlogsBlogsBlogsBlogsBlogsBlogs