- Usługi

Rozwiązania technologiczne

Rozwiązania technologiczne- Strategia Produku i Projektowanie Doświadczeń UżytkownikaZdefiniuj łańcuchy wartości oparte na oprogramowaniu, twórz celowe interakcje oraz rozwijaj nowe segmenty i oferty.

- Cyfrowa Transformacja BiznesuDostosuj się, rozwijaj i osiągaj sukcesy w cyfrowym świecie.

- Inteligentna InżynieriaWykorzystaj dane i sztuczną inteligencję do przekształcania produktów, operacji i wyników.

- Inżynieria OprogramowaniaPrzyspiesz dostarczanie produktów, platform i usług.

- Modernizacja TechnologiiZwiększ efektywność i elastyczność dzięki zmodernizowanym systemom i aplikacjom.

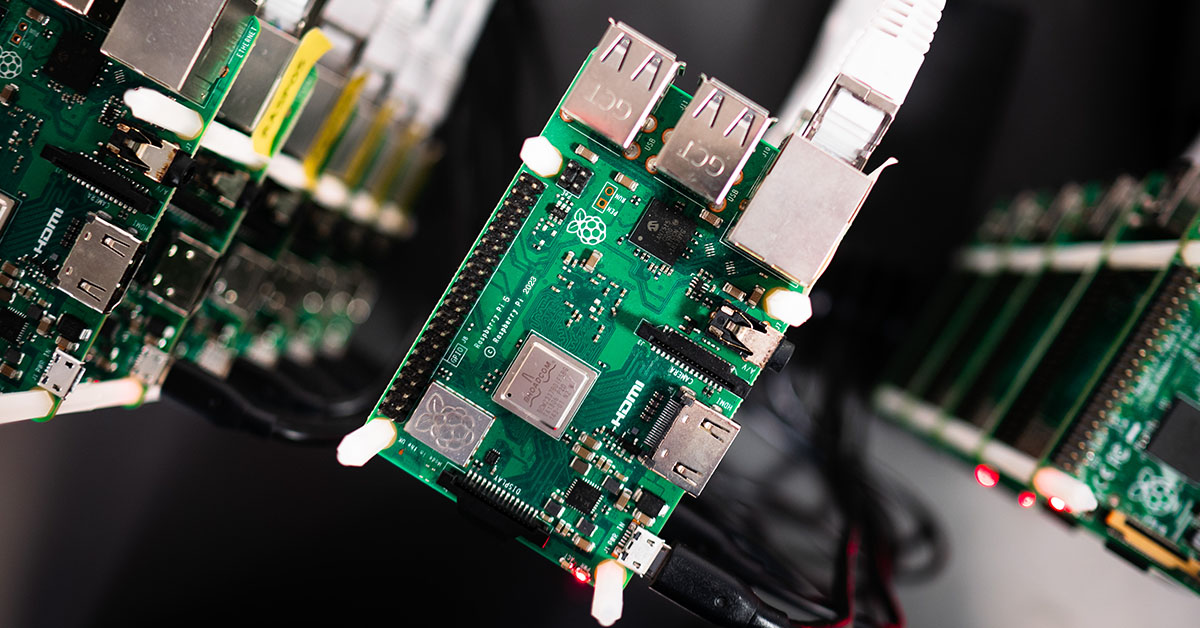

- Inżynieria Systemów Wbudowanych + Transformacja IT/OTTwórz i utrzymuj oprogramowanie typu chip-to-cloud dla produktów sieciowych

- Branże

- GlobalLogic VelocityAI

- Blog

BlogsGlobalLogicSeptember 4, 2024Dla dzikich pszczół i nas wszystkich – od inspiracji po ...

W świecie innowacji każdy pomysł ma znaczenie. Nawet drobne idee mogą prowadzić do rewo...

BlogsGlobalLogicJuly 24, 2024

BlogsGlobalLogicJuly 24, 2024Co oznacza kreatywność w IT? Z wizytą w GlobalLogic Gdańsk

Czy wiesz, że za pomocą kodu można skomponować symfonię, a sztuczna inteligencja potraf...

- O nas

Press ReleaseGlobalLogicJanuary 10, 2025GlobalLogic informuje o zmianach w zarządzie: stanowisko prezesa ...

SANTA CLARA, Kalifornia, 10.01.2025 – GlobalLogic, spółka należąca do Grupy Hitachi i l...

Press ReleaseGlobalLogicJanuary 7, 2025

Press ReleaseGlobalLogicJanuary 7, 2025GlobalLogic i Hitachi otwierają nowoczesne Security Operations ...

Hitachi Cyber i GlobalLogic otwierają nowoczesne Centrum Operacji Bezpieczeństwa (SOC) ...

- Kariera

Published on January 13, 2023Sztuczna inteligencja będzie decydować o życiu i śmierci człowieka

UdostępnijPowiązane spostrzeżenia GlobalLogic17 February 2025

GlobalLogic17 February 2025 GlobalLogic12 February 2025View All Insights

GlobalLogic12 February 2025View All Insights GlobalLogic12 February 2025

GlobalLogic12 February 2025Let's start engineering impact together

GlobalLogic provides unique experience and expertise at the intersection of data, design, and engineering.

Get in touchAI GovernanceMLOpsCross-IndustryPokładając wiarę w możliwości sztucznej inteligencji, w wielu branżach i obszarach życia oczekuje się od niej rozwiązywania najczęstszych lub najtrudniejszych problemów. Takie założenie sprawia też, że spodziewamy się od niej podejmowania decyzji w sprawach, w których nawet ludzie nie potrafią być jednomyślni – na przykład o kolejności ratowania rannych w wypadkach lub katastrofach.Sztuczna inteligencja ratująca ludzkie życie

Mawia się, że w trudnych sytuacjach zwykli ludzie potrafią dokonywać niezwykłych czynów. Tak właśnie powstały się historie wielu bohaterów – w obliczu niespodziewanego i trudnego wyzwania potrafili podjąć najlepsze na dany moment decyzje, często ratując własne bądź innych życie. W niedalekiej przyszłości jak się okazuje ich role przejmą algorytmy, które niezawodnie i skutecznie wyegzekwują w każdej sytuacji plan działania pozwalający ocalić jak największą liczbę ludzkich istnień.

Odpowiedzialne zadanie ma spocząć na barkach wciąż rozwijanej przez programistów sztucznej inteligencji. Bazujące na ogromnej ilości danych algorytmy zastąpią doświadczonych ludzkich ekspertów i pomogą ratownikom, podejmując w teorii lepsze decyzje szybciej, a przez to też optymalizując działania w taki sposób, by zminimalizować liczbę ofiar klęsk żywiołowych, zamachów terrorystycznych, wojen czy epidemii.

Tak wyglądają założenia projektu „In the Moment”, który opracowuje amerykańska Agencja Departamentu Obrony ds. Zaawansowanych Projektów Badawczych (DARPA – Defense Advanced Research Projects Agency). Rozwiązanie ma być dostosowane do działania w trudnych, dynamicznie zmieniających się warunkach i pozwolić na podejmowanie obiektywnie najrozsądniejszych decyzji tam, gdzie nie sposób określić, jaki wybór byłby tym właściwym.

W ramach programu przewidziane jest kilka faz treningu i rozwoju algorytmów, które będą stopniowo mierzyć się z coraz bardziej skomplikowanymi i wymagającymi scenariuszami. Zaczynając od działań o niedużej skali, po hipotetyczne sytuacje, w których na szali są setki tysięcy istnień, algorytmy będą doskonalić się w sztuce podejmowania decyzji w warunkach, które cechuje niepewność, złożoność, presja czasu, a często też konflikt interesów.

Ambitne założenia już na etapie projektowym wywołują liczne dyskusje. Jednym z najczęściej zadawanych pytań jest to o etyczne podstawy działania sztucznej inteligencji w opisywanej roli i jej zastosowanie do tak odpowiedzialnych zadań.

Jak sztuczna inteligencja może decydować o ratowaniu życia, nie mając sumienia

Czy pozbawiony uczuć, empatii i sumienia algorytm może podejmować właściwe decyzje dotyczące życia ludzi? Czy rzeczywiście można zaufać jego wskazówkom i poleceniom? Wizja oddelegowania tak trudnych wyborów w ręce sztucznej inteligencji wywołuje wiele dyskusji. Uzasadnione obawy napędzane są przez znane już przypadki uprzedzonych algorytmów. Stronniczość w sytuacjach zagrożenia życia może prowadzić do katastrofalnych skutków i niezgodnych z pierwotnymi założeniami projektu nieracjonalnych decyzji. Naukowcy wskazują na przykład, że w miejsce zdroworozsądkowych przesłanek, które pozwoliłyby ocalić jak największą grupę poszkodowanych, algorytm może zdecydować o ratowaniu przedstawicieli określonej profesji, grupy społecznej czy kategorii wiekowej, przyjmując za wzór określone kryteria.

Rola właściwego nauczenia algorytmów, pozwalająca im działać w oparciu o fakty i obiektywne przesłanki, jest niebagatelna. Wiedzą o tym autorzy projektu, którzy podkreślają znaczenie doświadczonych, działających od lat w sytuacjach kryzysowych ludzkich specjalistów. Ich udział w szkoleniach pozwoli SI właściwie ukształtować fundamenty umożliwiające właściwy osąd. Wszelkie decyzje podejmowane przez sztuczną inteligencję będą konfrontowane w zderzeniu właśnie z postępowaniem i wyborami człowieka.

Nawet jednak przyjmując obiektywizm algorytmów pełniących odpowiedzialną funkcję dowódcy działań ratunkowych, nie sposób nie dostrzec społecznych konsekwencji takiej zmiany. W dramatycznych okolicznościach często nie uda się uniknąć śmierci pewnej grupy ofiar. Co z ich bliskimi, którzy będą musieli pogodzić się ze świadomością, że zadecydował o tym algorytm? Pozbawiona sumienia i poczucia winy sztuczna inteligencja nie będzie mogła powiedzieć przepraszam. Nie okaże im współczucia i zrozumienia.

Poddawana w wątpliwość moralność technologii napędza obawy, choć być może rzeczywistość już wkrótce sama zweryfikuje ich słuszność i sprawi, że staną się bezzasadne. Od wielu miesięcy każdy może zapytać o moralną ocenę danego zdarzenia czy zachowania algorytm Delphi opracowany przez Allen Institute for AI. W oparciu o udostępnioną bazę danych składającą się z milionów odpowiedzi Amerykanów, ocenia on wybory i odpowiada na pytania ze skutecznością na poziomie 92%, jak weryfikowali do tej pory sami pytający. Pomimo prototypowego stanu jest nad wyraz trafny w swoich ocenach, choć nie jest też wolny od wspomnianych wcześniej uprzedzeń, które wystąpiły we wzorcowej bazie informacji – w społeczeństwie.

Ten aspekt odpowiednich źródeł wiedzy jest w przypadku projektów podobnych do “In the Moment” kluczowy, ponieważ głębokie uczenie nie opiera się wówczas na ground truth (danych prawdziwych – rzeczywistych).

Czym jest ground truth w machine learning

Uczenie maszynowe pozwala algorytmom doskonalić się w rozpoznawaniu rzeczywistości i działaniu zgodnie z ustalonymi założeniami, tak by skuteczniej i szybciej realizować określone zadania. Ground truth stanowi w tym przypadku fundament, na którym zdobywają niezbędną wiedzę o otaczającym świecie. To zbiór danych definiujący rzeczywistość i wyznaczający idealny efekt końcowy lub właśnie cel dla algorytmu, do którego może się w swoich działaniach zbliżać.

W wielu przypadkach uczenie sztucznej inteligencji z wykorzystaniem ground truth jest możliwe, ponieważ dotyka tematów łatwo definiowalnych, oczywistych, możliwych do obiektywnej oceny. Takim fundamentem są chociażby znaki i zasady ruchu drogowego, które pozwalają poruszać się autonomicznym samochodom zgodnie z przepisami, a tym samym bezpiecznie.

W przypadku sytuacji dotyczących życia i śmierci takiej bazy nie ma, bo nie ma w nich jednej, dobrej decyzji. Nie istnieje uniwersalny przepis na sukces, który mogą zaadaptować nowe technologie. Widać to po zachowaniach samych ludzi. Często dwóch specjalistów mających za zadanie przeprowadzić akcję ratunkową podejmie zupełnie różne decyzje i postawi na odmienne scenariusze. W takich okolicznościach, kiedy nawet nauczyciele nie są zgodni, trudno oczekiwać, by uczeń był bezbłędny i potrafił zadowolić każdą ze stron.

Rozwój sztucznej inteligencji – programując bezpieczną przyszłość

Sztuczna inteligencja jako technologia ma potencjał, by pozwolić nam lepiej ratować ludzkie życie. Już teraz widać jej możliwości w medycynie, gdzie algorytmy stanowią wsparcie dla lekarzy w skutecznym diagnozowaniu pacjentów na całym świecie. Często przyspieszają leczenie i pozwalają błyskawicznie reagować w sytuacjach zagrożenia życia. Za ich dalszym rozwojem, których efektem będzie też opracowanie rozwiązań skutecznie kierujących akcjami ratunkowymi w przypadku wojny czy kataklizmu, stoją tysiące inżynierów oprogramowania. To ich codzienna praca, która dalece wykracza poza zwykłe pisanie kodu, zmienia rzeczywistość wokół nas. Poprzez projekty kreują nowy, lepszy świat i pomagają unowocześniać się branży medycznej, motoryzacyjnej czy przemysłowej.

Zainteresował Cię powyższy temat? Chciałbyś pracować dla klientów wdrażających innowacje w swoich sektorach? Zachęcamy do sprawdzenia ofert pracy w GlobalLogic i poznania bliżej historii naszych specjalistów, którzy zmieniają świat kierowców, pacjentów i lekarzy, rozwijając innowacyjne systemy czy urządzenia. Zobacz, jak Ty możesz współpracować z wybitnymi inżynierami i swoją pracą wywoływać efekty dalece wykraczające poza zwykły komputerowy kod.