- Usługi

Rozwiązania technologiczne

Rozwiązania technologiczne- Strategia Produku i Projektowanie Doświadczeń UżytkownikaZdefiniuj łańcuchy wartości oparte na oprogramowaniu, twórz celowe interakcje oraz rozwijaj nowe segmenty i oferty.

- Cyfrowa Transformacja BiznesuDostosuj się, rozwijaj i osiągaj sukcesy w cyfrowym świecie.

- Inteligentna InżynieriaWykorzystaj dane i sztuczną inteligencję do przekształcania produktów, operacji i wyników.

- Inżynieria OprogramowaniaPrzyspiesz dostarczanie produktów, platform i usług.

- Modernizacja TechnologiiZwiększ efektywność i elastyczność dzięki zmodernizowanym systemom i aplikacjom.

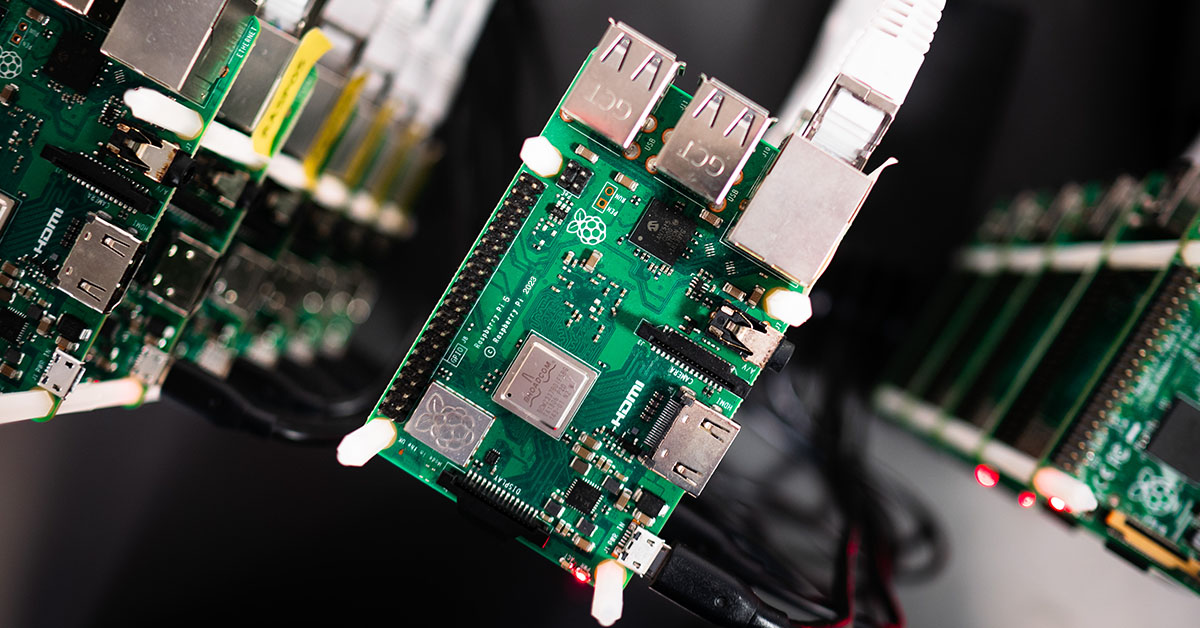

- Inżynieria Systemów Wbudowanych + Transformacja IT/OTTwórz i utrzymuj oprogramowanie typu chip-to-cloud dla produktów sieciowych

- Branże

- GlobalLogic VelocityAI

- Blog

BlogsGlobalLogicSeptember 4, 2024Dla dzikich pszczół i nas wszystkich – od inspiracji po ...

W świecie innowacji każdy pomysł ma znaczenie. Nawet drobne idee mogą prowadzić do rewo...

BlogsGlobalLogicJuly 24, 2024

BlogsGlobalLogicJuly 24, 2024Co oznacza kreatywność w IT? Z wizytą w GlobalLogic Gdańsk

Czy wiesz, że za pomocą kodu można skomponować symfonię, a sztuczna inteligencja potraf...

- O nas

Press ReleaseGlobalLogicJanuary 10, 2025GlobalLogic informuje o zmianach w zarządzie: stanowisko prezesa ...

SANTA CLARA, Kalifornia, 10.01.2025 – GlobalLogic, spółka należąca do Grupy Hitachi i l...

Press ReleaseGlobalLogicJanuary 7, 2025

Press ReleaseGlobalLogicJanuary 7, 2025GlobalLogic i Hitachi otwierają nowoczesne Security Operations ...

Hitachi Cyber i GlobalLogic otwierają nowoczesne Centrum Operacji Bezpieczeństwa (SOC) ...

- Kariera

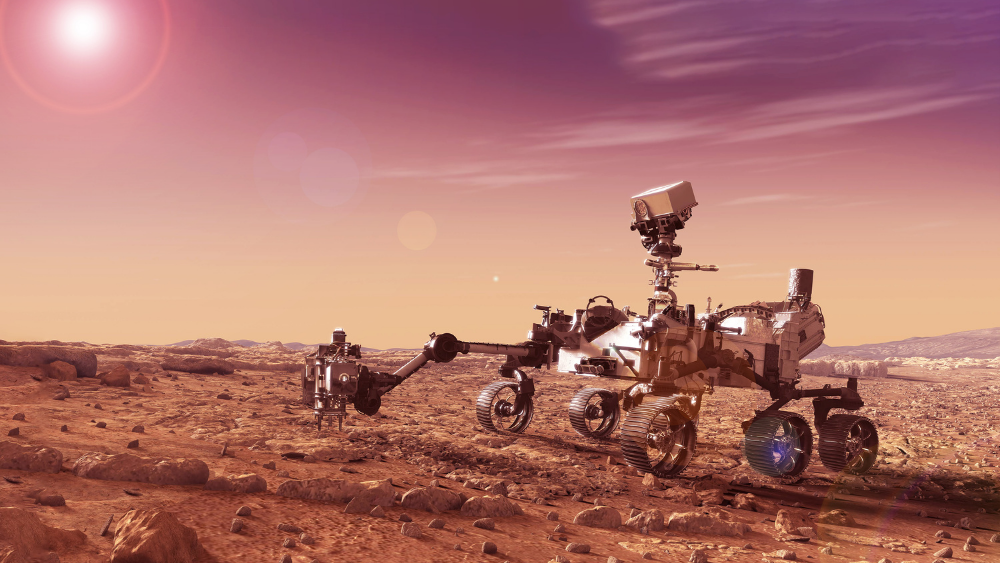

Published on April 5, 2021W odkurzaczu, samochodzie i marsjańskim łaziku – technologia SLAM

View all articles GlobalLogic PolandUdostępnijPowiązane spostrzeżenia

GlobalLogic PolandUdostępnijPowiązane spostrzeżenia GlobalLogic17 February 2025

GlobalLogic17 February 2025 GlobalLogic12 February 2025View All Insights

GlobalLogic12 February 2025View All Insights GlobalLogic12 February 2025

GlobalLogic12 February 2025Let's start engineering impact together

GlobalLogic provides unique experience and expertise at the intersection of data, design, and engineering.

Get in touchCross-IndustryDzięki zmysłom poruszamy się bezpiecznie i precyzyjnie, nawet w miejscach, które odwiedzamy po raz pierwszy w życiu. Rozwój autonomicznych robotów i pojazdów zakłada, że one również będą w stanie poradzić sobie w podobnych sytuacjach. Umożliwia to upowszechniająca się technologia SLAM, którą znajdziemy wszędzie – od domowego odkurzacza, przez autonomiczny samochód, po marsjańskiego łazika.

Czego przede wszystkim potrzebuje autonomiczny robot lub pojazd? Musi umieć obserwować swoje otoczenie i potrafić dynamicznie reagować na zmieniającą się wokół niego sytuację, by unikać niebezpiecznych zdarzeń i wypadków. Zastosowania w tym kontekście znajduje właśnie wspomniana na wstępie technologia SLAM (Simultaneous Localization and Mapping), dzięki której samodzielnie poruszająca się maszyna może definiować swoje położenie i tworzyć oraz aktualizować mapę otoczenia, po którym się porusza.

Mapowanie otoczenia jest możliwe dzięki danym pozyskanym z sensorów. W zależności od tego, jakiego rodzaju czujniki posiada i w jakiej formie „obserwuje” rzeczywistość, mówimy o jednym z kilku rodzajów technologii SLAM.

Visual SLAM (VSLAM), LiDAR SLAM i Acoustic SLAM

Autonomiczna maszyna funkcjonuje w podobny sposób jak człowiek, gdy mowa o poruszaniu się po nieznanym obszarze. My korzystamy z naszych zmysłów, by określać swoje położenie, wykrywać przeszkody i zagrożenia oraz definiować najlepszą drogę do celu. W przypadku robotów i pojazdów zadanie to wykonują różnego rodzaju sensory, które dostarczają potrzebnych danych do przetworzenia. Sposób obserwacji i zbierania informacji przez system wpływa na różnice definiujące rodzaje technologii SLAM.

Visual SLAM, jak sama nazwa wskazuje, wykorzystuje odczyty wizualne, a więc obserwacje dokonane za pomocą kamer oraz czujników reagujących choćby na kolor i światło. VSLAM oferuje spore możliwości w zakresie implementacji ze względu na dostępne obecnie rodzaje kamer.

Jest przy tym rozwiązaniem stosunkowo ekonomicznym i przystępnym finansowo we wdrożeniu, co wpływa na jego popularność i mnogość zastosowań. W zależności od potrzeb i wymagań, w danej maszynie mogą zostać zastosowane kamery typu rybie oko, panoramiczne, RGBD (Red Green Blue Depth) czy TOF (Time-of-Flight), które mierzą czas, w jakim światło wraca do czujnika po odbiciu się od danego obiektu.

Odmianą SLAM, która zapewnia wysoki poziom precyzji, jest ta bazująca na technologii LiDAR (Light Detection and Ranging). Wykorzystuje ona obserwacje dokonywane na bazie odczytów rozproszonego światła, wyemitowanego wcześniej przez pojazd w postaci impulsów. Sensor laserowy zapewnia dużą dokładność i niezależność od panujących warunków oświetlenia, co jest szczególnie ważne w sytuacjach, w których trudno przewidzieć okoliczności, w jakich przyjdzie funkcjonować autonomicznemu robotowi. W tym przypadku również nie możemy jednak mówić o doskonałości rozwiązania – SLAM oparty o LiDAR nie jest bezbłędny, a problemy sprawiają mu choćby obiekty o nieregularnym kształcie.

Łatwo możemy wyobrazić sobie miejsca, w których czerpanie informacji z obserwacji wizualnych jest niemożliwe lub poważnie utrudnione. Maszyny poruszające się w takich warunkach potrzebują innego źródła danych. Może nim być dźwięk, co pokazuje opracowywany przez inżynierów Acoustic SLAM, w którym tworzone na bieżąco wirtualne plany przestrzenne bazują na sygnałach zbieranych przez mikrofony.

Atutem tego rozwiązania jest fakt, że w porównaniu do analiz wizualnych, wymaga mniejszych nakładów mocy obliczeniowej do przetworzenia danych, a tym samym stanowi optymalne wyjście w przypadku układów, których konstruktorzy nie chcą zbytnio obciążać. Także jednak i ta metoda nie jest jeszcze bezbłędna. Projektanci stawiają czoła m.in. problemowi echa, które może wprowadzać maszyny w błąd.

SLAM w praktyce

Wiele branż szybko dostrzegło potencjał technologii SLAM. To nieuniknione, wszak coraz częściej mówimy o zatrudnianiu do konkretnych zadań samodzielnych robotów i upowszechnianiu autonomicznych pojazdów. Niezależnie od rozmiaru maszyny – czy to dron, czy samochód, SLAM stanowi równie praktyczne rozwiązanie. Jednocześnie jest odpowiedzią na potrzeby sektorów, dla których sprawdzony od lat model poruszania się maszyn, choćby na bazie danych GPS, przestał być wystarczający. Gdzie więc możemy już dzisiaj spotkać się z przykładami zastosowania SLAM?

Skalę użycia technologii najlepiej zobrazujemy, wspominając, że obecna jest zarówno w jeżdżących po wielu domach autonomicznych odkurzaczach, jak i w łazikach kosmicznych mających realizować misje o kolosalnym znaczeniu dla całej ludzkości. W przypadku jednego z popularnych modeli odkurzaczy, jego optyczne sensory zbierają w każdej sekundzie informacje z ponad 230 000 punktów, dzięki czemu system jest w stanie określić swoje położenie, a także wyznaczyć miejsca, w których już sprzątał i w które jeszcze powinien pojechać. Jeśliby więc mówić o funkcji technologii, pełni ona rolę radaru i oczu.

SLAM pojawia się tam, gdzie mowa o samodzielnych wytworach mechanicznych. Możemy o niej mówić w kontekście samochodów autonomicznych, co pokazuje przykład rozwijającego się projektu Google Waymo. Wymienia się ją również w kontekście smart robotów, zarówno tych projektowanych z myślą o zadaniach przemysłowych, jak i dla użytkowników indywidualnych.

W GlobalLogic tworzymy oprogramowanie dla samochodów przyszłości, współpracując z najlepszymi producentami branży automotive. Sprawdź, jakie rozwiązania możemy zaproponować firmom z branży motoryzacyjnej.

W tym drugim przypadku SLAM ma pozwolić im nie tylko samodzielnie się poruszać, ale również bez pomocy odnaleźć i dotrzeć do użytkownika. Jak szerokie spektrum możliwości to otwiera pokazuje przykład prototypu CanguRo opracowanego przez Future Robotics Technology Center Instytutu Technologii Chiba. Szczególnie intrygująco zapowiada się jednak ewolucja, do której dojdzie w przemyśle.

Dzięki SLAM możemy być już wkrótce świadkami zmiany warty w fabrykach czy magazynach, w których automatyczne roboty (AGV – Automated Guided Vehicle) zastąpią ich doskonalsi, autonomiczni następcy (AMR – Autonomous Mobile Robots). Zaawansowane algorytmy wykorzystywane w tego rodzaju maszynach pozwolą zwiększyć zakres ich zadań, a jednocześnie zadbać o bezpieczeństwo w danym środowisku pracy.

Wykorzystując technologiczne możliwości, mechaniczni pracownicy będą w stanie unikać kolizji z ludźmi i innymi robotami oraz reagować na zachodzące w ich otoczeniu zmiany. To z kolei może przełożyć się na większą efektywność, nie tylko w skali każdego smart robota, ale również całego przedsiębiorstwa.

Na bazie obserwacji dokonanych przez maszyny i przekazywanych do systemu, organizacja będzie w stanie optymalizować procesy i usprawniać np. współpracę maszyn i ludzi przy konkretnych zadaniach. Takie perspektywy przekładają się na wzrost zainteresowania AMR, których liczba ma przekroczyć 15 milionów w 2030 roku.

Zastanawiasz się, jaka przyszłość czeka motoryzację? Przeczytaj również artykuł: Zmiennokształtny samochód przyszłości.

Samodzielny robot

SLAM sprawi, że roboty zyskają wzrok i słuch oraz będą w stanie ze zbieranych danych zrobić praktyczny użytek, podejmując odpowiednie decyzje w czasie rzeczywistym. Co za tym idzie, będą mogły swobodniej poruszać się w przestrzeni, realizując jeszcze większy zakres powierzanych im zadań. Jednak ile rzeczywiście prac będzie można oddać w ręce smart robota? W jakim stopniu będą one samodzielne? To dopiero pokaże czas.

Z pewnością jednak czeka nas znacząca ewolucja w pewnych sektorach, w tym w przemyśle i logistyce, co najmniej na miarę tej z połowy ubiegłego stulecia, kiedy w magazynach zaczęły pojawiać się automatyczne roboty.

Technologia SLAM – kariera w GlobalLogic

Chcesz być nie tylko świadkiem, ale także uczestnikiem kreowania nowej, cyfrowej rzeczywistości? Dołącz do GlobalLogic – lidera w branży usług inżynierii cyfrowej.

Czeka tu na Ciebie wiele ambitnych i rozwijających projektów. Do tej pory współpracowaliśmy między innymi z takimi markami, jak Volvo, Adobe, HP czy McDonald’s.

Możesz pracować w jednym z sześciu biur w Polsce (Wrocławiu, Krakowie, Szczecinie, Koszalinie, Zielonej Górze lub Bydgoszczy) lub realizować się w pracy zdalnej bądź hybrydowej.

Odwiedź zakładkę kariera, aby przekonać się, co dokładnie możemy Ci zaoferować i kogo aktualnie szukamy. Do zobaczenia!

Polecane materiały w temacie SLAM:

Accoustic SLAM – publikacja Christine Evers i Patricka A. Naylora

Acoustic SLAM — State of the Art: Review – publikacja Baraka Ora